De afgelopen maanden is de kunstmatige-intelligentiegemeenschap overspoeld met een verhit debat dat op gang is gebracht door twee invloedrijke onderzoekspapers die door apple zijn gepubliceerd. Het eerste, illusion-of-thinking-the-debat-that-is-shaking-the-world-of-ai&_bhlid=a540c17e5de7c2723906dabd9b8f31cdf0c5bf18" target="_blank" id="">"GSM-Symbolic" (oktober 2024), en het tweede, "De illusie van het denken" (juni 2025) werden de vermeende redeneercapaciteiten van Grote Taalmodellen in twijfel getrokken, wat gemengde reacties uitlokte in de hele sector.

Zoals reeds besproken in onze vorige diepgaande analyse over "De illusie van vooruitgang: algemene kunstmatige intelligentie simuleren zonder deze te bereiken", raakt de kwestie van kunstmatig redeneren de kern van wat we beschouwen als intelligentie in machines.

Onderzoekers van Apple voerden een systematische analyse uit op Large Reasoning Models (LRM) - modellen die gedetailleerde redeneersporen genereren voordat ze een antwoord geven. De resultaten waren verrassend en, voor velen, alarmerend.

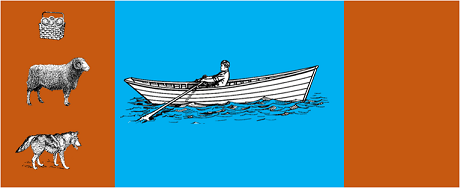

Het onderzoek onderwierp de meest geavanceerde modellen aan klassieke algoritmische puzzels zoals:

De resultaten toonden aan dat zelfs kleine veranderingen in de probleemformulering leiden tot significante variaties in prestaties, wat wijst op een zorgwekkende kwetsbaarheid in redeneren. Zoals gemeld in AppleInsider"de prestaties van alle modellen nemen af wanneer alleen de numerieke waarden in de GSM-Symbolic benchmarkvragen worden gewijzigd".

De reactie van de AI-gemeenschap liet niet lang op zich wachten. Alex Lawsen van Open Philanthropy, in samenwerking met Claude Opus van Anthropic, publiceerde een gedetailleerd weerwoord met de titel "De illusie van denken.waarin de methodologie en conclusies van het Apple onderzoek worden aangevochten.

Toen Lawsen de tests herhaalde met alternatieve methodes - door de modellen te vragen recursieve functies te genereren in plaats van alle zetten op te sommen - waren de resultaten dramatisch anders. Modellen zoals Claude, gemini en GPT losten Toren van Hanoi problemen met 15 records correct op, ver voorbij de complexiteit waarbij Apple nul successen rapporteerde.

Gary Marcuseen lange tijd criticus van de redeneervaardigheden van LLM's, omarmde de bevindingen van Apple als een bevestiging van zijn 20-jarige thesis. Volgens Marcus blijven LLM's worstelen met 'distributieverschuiving' - het vermogen om te generaliseren buiten de trainingsgegevens om - terwijl ze 'goede oplossers blijven van problemen die al zijn opgelost'.

De discussie heeft zich ook verspreid naar gespecialiseerde gemeenschappen zoals LocalLlama op Redditwaar ontwikkelaars en onderzoekers debatteren over de praktische implicaties voor open-source modellen en lokale implementatie.

Dit debat is niet louter academisch. Het heeft directe gevolgen voor:

Zoals benadrukt in verschillende technische inzichtenis er een toenemende behoefte aan hybride benaderingen die:

Triviaal voorbeeld: een AI-assistent die helpt met boekhouden. Het taalmodel begrijpt wanneer je vraagt "hoeveel heb ik deze maand uitgegeven aan reizen?" en haalt de relevante parameters eruit (categorie: reizen, periode: deze maand). Maar de SQL-query die de database bevraagt, de som berekent en de fiscale beperkingen controleert? Dat wordt gedaan door deterministische code, niet door het neurale model.

Het is waarnemers niet ontgaan dat het Apple-paper kort voor WWDC werd gepubliceerd, wat vragen oproept over de strategische beweegredenen. Zoals deanalyse van 9to5Mac"De timing van de Apple paper - vlak voor WWDC - deed een paar wenkbrauwen fronsen. Was dit een mijlpaal in het onderzoek of een strategische zet om Apple opnieuw te positioneren in het bredere AI-landschap?"

Het debat dat op gang is gebracht door de documenten van Apple herinnert ons eraan dat we nog maar aan het begin staan van het begrijpen van kunstmatige intelligentie. Zoals aangegeven in ons vorig artikelblijft het onderscheid tussen simulatie en authentiek redeneren een van de meest complexe uitdagingen van onze tijd.

De echte les is niet of LLM's al dan niet kunnen 'redeneren' in de menselijke betekenis van het woord, maar eerder hoe we systemen kunnen bouwen die hun sterke punten uitbuiten en tegelijkertijd hun beperkingen compenseren. In een wereld waarin AI al hele sectoren transformeert, is de vraag niet langer of deze hulpmiddelen 'slim' zijn, maar hoe we ze effectief en verantwoord kunnen gebruiken.

De toekomst van ondernemings-AI ligt waarschijnlijk niet in één revolutionaire benadering, maar in de intelligente orkestratie van verschillende complementaire technologieën. En in dit scenario wordt het vermogen om de mogelijkheden van onze tools kritisch en eerlijk te evalueren zelf een concurrentievoordeel.

Laatste ontwikkelingen (januari 2026)

OpenAI brengt o3 en o4-mini uit: Op 16 april 2025 heeft OpenAI o3 en o4-mini, de meest geavanceerde redeneringsmodellen uit de o-serie, openbaar gemaakt. Deze modellen kunnen nu op agentieve wijze gebruikmaken van tools, waarbij ze webonderzoek, bestandsanalyse, visueel redeneren en beeldgeneratie combineren. o3 heeft nieuwe records gevestigd op benchmarks zoals Codeforces, SWE-bench en MMMU, terwijl o4-mini de prestaties en kosten voor redeneringstaken met een hoog volume optimaliseert. De modellen tonen het vermogen om 'met beelden te denken', waarbij inhoud visueel wordt omgezet voor diepgaandere analyses.

DeepSeek-R1 schudt de AI-industrie wakker: in januari 2025 bracht DeepSeek R1 uit, een open-source redeneringsmodel dat vergelijkbare prestaties leverde als OpenAI o1, met trainingskosten van slechts 6 miljoen dollar (tegenover honderden miljoenen voor westerse modellen). DeepSeek-R1 bewijst dat redeneervaardigheden kunnen worden gestimuleerd door middel van pure reinforcement learning, zonder dat daarvoor door mensen geannoteerde demonstraties nodig zijn. Het model werd de nummer 1 gratis app in de App Store en Google Play in tientallen landen. In januari 2026 publiceerde DeepSeek een uitgebreid artikel van 60 pagina's waarin de geheimen van de training worden onthuld en openhartig wordt toegegeven dat technieken zoals Monte Carlo Tree Search (MCTS) niet hebben gewerkt voor algemeen redeneren.

Anthropic werkt de 'grondwet' van Claude bij: Op 22 januari 2026 publiceerde Anthropic een nieuwe grondwet van 23.000 woorden voor Claude, waarbij het bedrijf overstapte van een op regels gebaseerde aanpak naar een aanpak die gebaseerd is op het begrijpen van ethische principes. Het document is het eerste kader van een groot AI-bedrijf dat formeel de mogelijkheid van bewustzijn of morele status van AI erkent, en stelt dat Anthropic zich bekommert om het "psychologisch welzijn, zelfbewustzijn en welzijn" van Claude.

Het debat wordt steeds heftiger: een studie uit juli 2025 heeft de benchmarks van Apple herhaald en verfijnd, en bevestigt dat LRM's nog steeds cognitieve beperkingen vertonen wanneer de complexiteit matig toeneemt (ongeveer 8 schijven in de Toren van Hanoi). De onderzoekers hebben aangetoond dat dit niet alleen te wijten is aan outputbeperkingen, maar ook aan echte cognitieve beperkingen, wat aantoont dat het debat nog lang niet is afgesloten.

Voor inzicht in de AI-strategie van je organisatie en de implementatie van robuuste oplossingen is ons team van experts beschikbaar voor consultaties op maat.